Файл Robots.txt: создание, настройка, проверка и индексация сайта

Продвижение сайта – очень важная вещь. Здесь важна каждая деталь и ваша задача: использовать всевозможные методы для продвижения сайта. Ведь зачастую успех бизнеса зависит и от того, сколько вы получите клиентов из интернета.

Поэтому вам следует прописать для робота всё, чтобы ему было максимально комфортно продвигать ваш сайт. «Но разве есть такая возможность?» - спросите вы. Конечно, есть. Нужна только 1 вещь. Специальный файл. Он называется «robots.txt».

И так, сегодня мы научим вас прописывать важные параметры в robots.txt правильно.

Robots.txt

Это просто текстовый файл, он содержит некоторые рекомендации специально для "поискового паука". Если у вас на сайте есть данный файл, то вы сможете указать роботу, что можно сканировать, а что нет.

Кодировка файла - UTF-8.

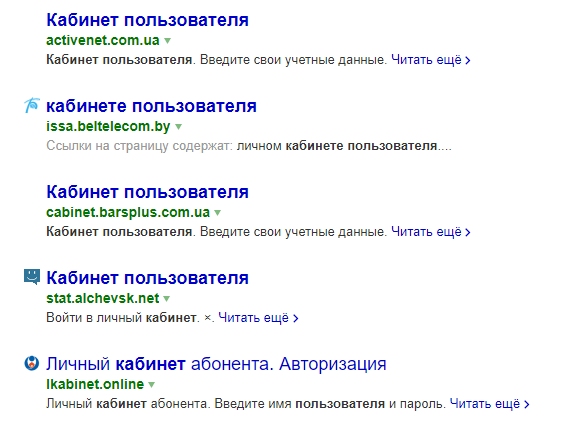

А если вы пропишите «роботс» неправильно, то в поисковики могут попасть нежелательные подстраницы сайта, такие как: кабинеты посетителей, вспомогательные страницы, зеркала и т.д.

Пример спама в поисковой выдаче

Поисковые пауки могут распознать 3 команды:

- Сканировать можно.

- Сканировать нельзя.

- Разрешается частичное сканирование.

Создаём правильный robots.txt для сайта

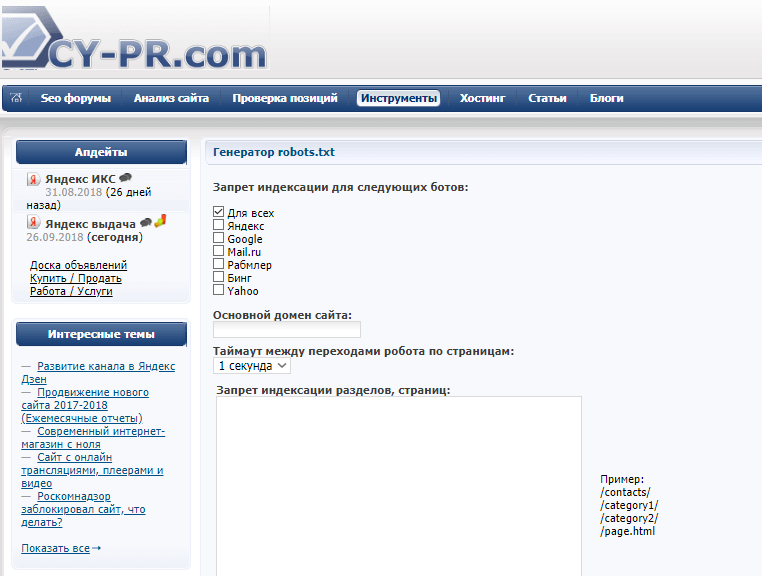

Команды можно прописать и в простом текстовом блокноте на вашем компьютере, но лучше использовать специальные сервисы в интернете, к примеру: CY-PR.com.

Сайт CY-PR.com

Следует уточнить, для каких поисковиков вы его оптимизируете, а потом интернет-сервис пропишет всё за вас. В принципе это задание можно дать вашему разработчику, но проверить файл будет не лишнем, поэтому, сейчас мы расскажем, как же создать файл роботс.

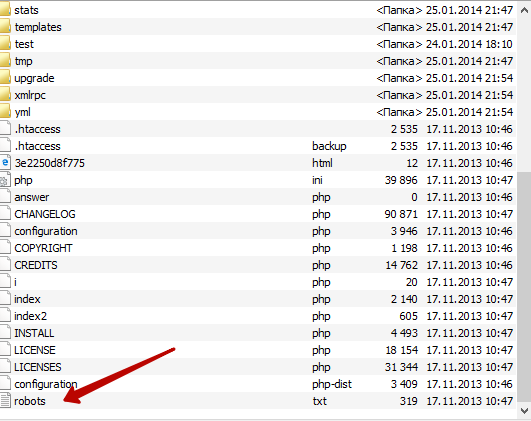

Местоположение Robots

Корневая папка

Файл делится на блоки. Обязательно, чтобы новый блок начинался строго с новой строки, в ином случае robots работать не будет. Один блок командует одним поисковым агентом. Но есть и специальный блок с указаниями для всех поисковиков.

Блок следует начинать со слов: «User-agent.»

В начале каждой строки пишем «:», «пробел» и указываем адрес. (например, страницу, для которой индексация нежелательна)

Внимание! Так же не мало важным фактором остаётся то, что нужно указывать именно относительные адреса страниц. К примеру, если вы хотите запретить показ этой страницы: «www.sitevsemachinki.ru/shopеthebestone», то вы пишете: Disallow: /shopthebestone.

«*» - любые цифры и буквы.

«$» - окончание строчки.

Настраиваем robots.txt

Блок делится на две части:

- Команда «User-agent», помогает определить роботу ту поисковую сеть, для которой правила ниже обязательны к исполнению.

- Сами команды запрета и доступа. Они идут ниже.

Disallow: Запрещает поисковику индексацию.

«Disallow» применяется, если вы хотите запретить показ страницы.

Например, закроем для индексации админ панель вашего сайта:

User-agent: *

Disallow: /wp-admin

«User-agent: *» - эта команда означает, что абсолютно все поисковые системы не будут индексировать страницу.

Важно! Всегда ставьте запрет на индексацию следующих страниц:- Админ. панель.

- Информации о покупках. (корзины)

- Личные страницы пользователей.

- Страницы входа, регистрации.

Где понадобится и для чего пригодится sitemap?

Это подсказка для робота, показывающая, что все страницы на том или ином адресе относятся к какому-то одному (главному) сайту. Если на этом файле будет sitemap, то роботу будет проще проиндексировать сайт. Итог: сайт индексируется гораздо быстрее.

Делается это вот так:

Sitemap: site.ru/sitemap.xml

Clean-param

В 2009 Yandex ввёл новую директиву. Она очень удобна и часто используется форумами. Всем известно, что на форумах часто информация дублируется и часто владелец данного форума даже не может повлиять на это, из-за этого возникает лишний «спам», которого можно было избежать, используя директиву clean-param.

Данный пункт можно прописать в robots.txt в любом месте.

То, что поисковому пауку учитывать не обязательно, пишется через знак «&», вот пример команды:

Clean-param: sid&sort /forum/viewforum.php

Crawl-delay

Данная директива очень полезна и точно пригодится в использовании тем владельцам сайтов, у которых слабый сервер. Думаю, всем понятно, что приход поискового робота – это дополнительная немалая нагрузка на сервер, а значит, если веб сайт имеет хорошую посещаемость, то велика доля вероятности, что данный сайт зависнет, робот же получит специальное уведомление об этой неприятной ситуации. Если же это повторится несколько раз, то робот признает сайт нерабочим, что так же не очень хочется.

Поэтому, вам следует прописать следующую команду:

Crawl-delay: 2

«2» - это частота, с которой робот проверяет ваши страницы. Частота снизится, а в следствии и загруженность понизится тоже.

Проверка robots.txt

И вот ура! Файл написан. Поздравляем. Но вот только правильно ли? Будет обидно, если из-за одной помарки поисковой робот просто не прочтёт ваши директивы. Поэтому, всегда нужно проверять правильность написания вашего файла.

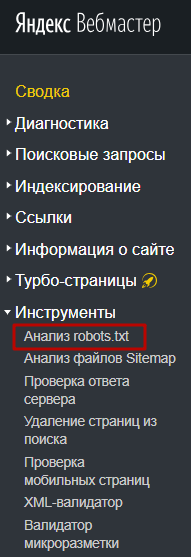

Для этого мы советуем использовать сервисы от Яндекса и Гугла.

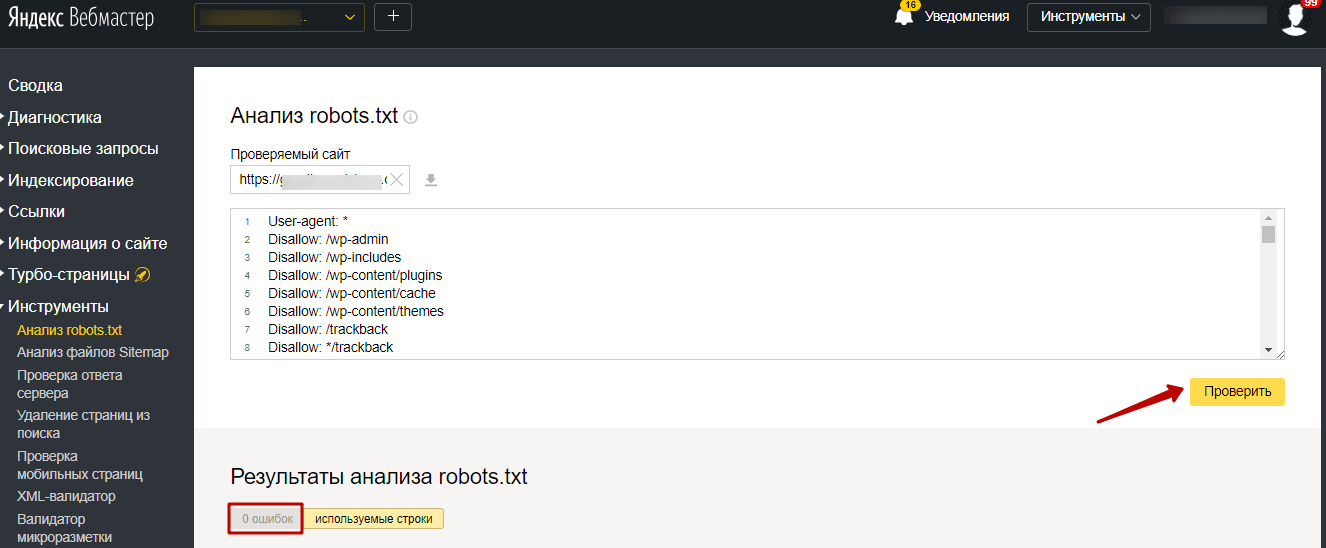

Заходим на Яндекс.Вебмастер, на вкладку «Инструменты – Анализ robots.txt»:

Проверка файла Robots.txt через Яндекс.Вебмастер

Укажите адрес интернет страницы, которую вы хотите проверить, а в поле ниже нужно скопировать все команды.

Следующем делом кликаем «Проверить» и ждём. Яндекс.Вебмастер сам подчеркнёт все неточности и помарки. Полезный инструмент, не правда ли?

Проверка файла Robots.txt через Яндекс.Вебмастер

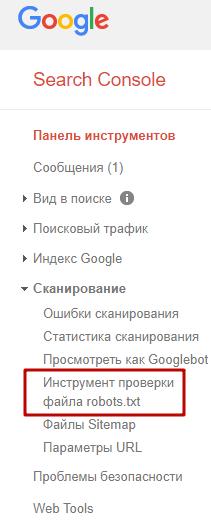

Но помимо Яндекс.Вебмастера ещё существует и Google Search Console. Через него вы так же можете провести анализ файла. Но к сожалению вам представится такая возможность, только если ваши права на сайт подтверждены.

Следуя инструкции на скриншоте, повторяем все действия.

Проверка файла Robots.txt через Google Search Console

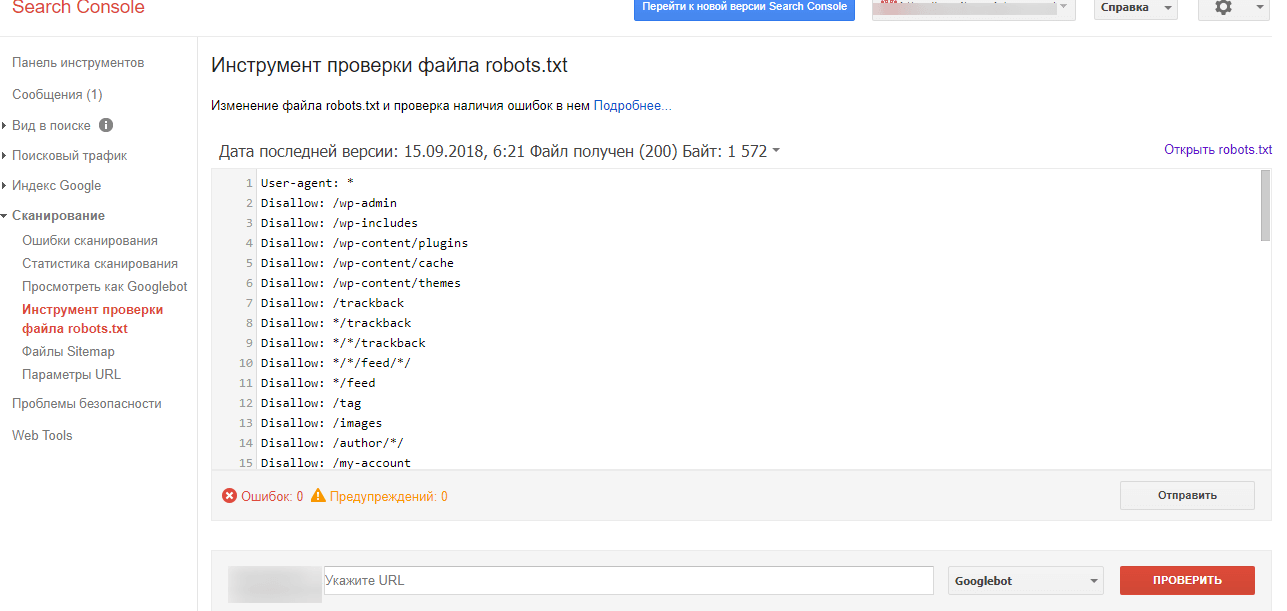

Затем проделываем те же самые действия, что и до этого, а то есть вставляем содержимое файла и адрес сайта. Теперь нажимаем «Проверить». Система сама укажет вам возможные ошибки.

Проверка файла Robots.txt через Google Search Console.

Вот с таким очень нужным и сильным инструментом для правильного seo продвижения сегодня мы познакомились. Будьте внимательными и заглядывайте в этот файл, вносите нужные правки. Это сильно поможет вам в развитии вашего бизнеса.

Желаем Вам успехов в продвижении. Не сдавайтесь и у вас всё получится!

До новых выпусков!

Была ли эта статья полезной?

Пользователи, считающие этот материал полезным: 0 из 0

Понравился пост?

Расскажи об этом посте своим друзьям!

Авторизуйтесь

Для синхронизации избранного и возможности добавлять комментарии

Войти